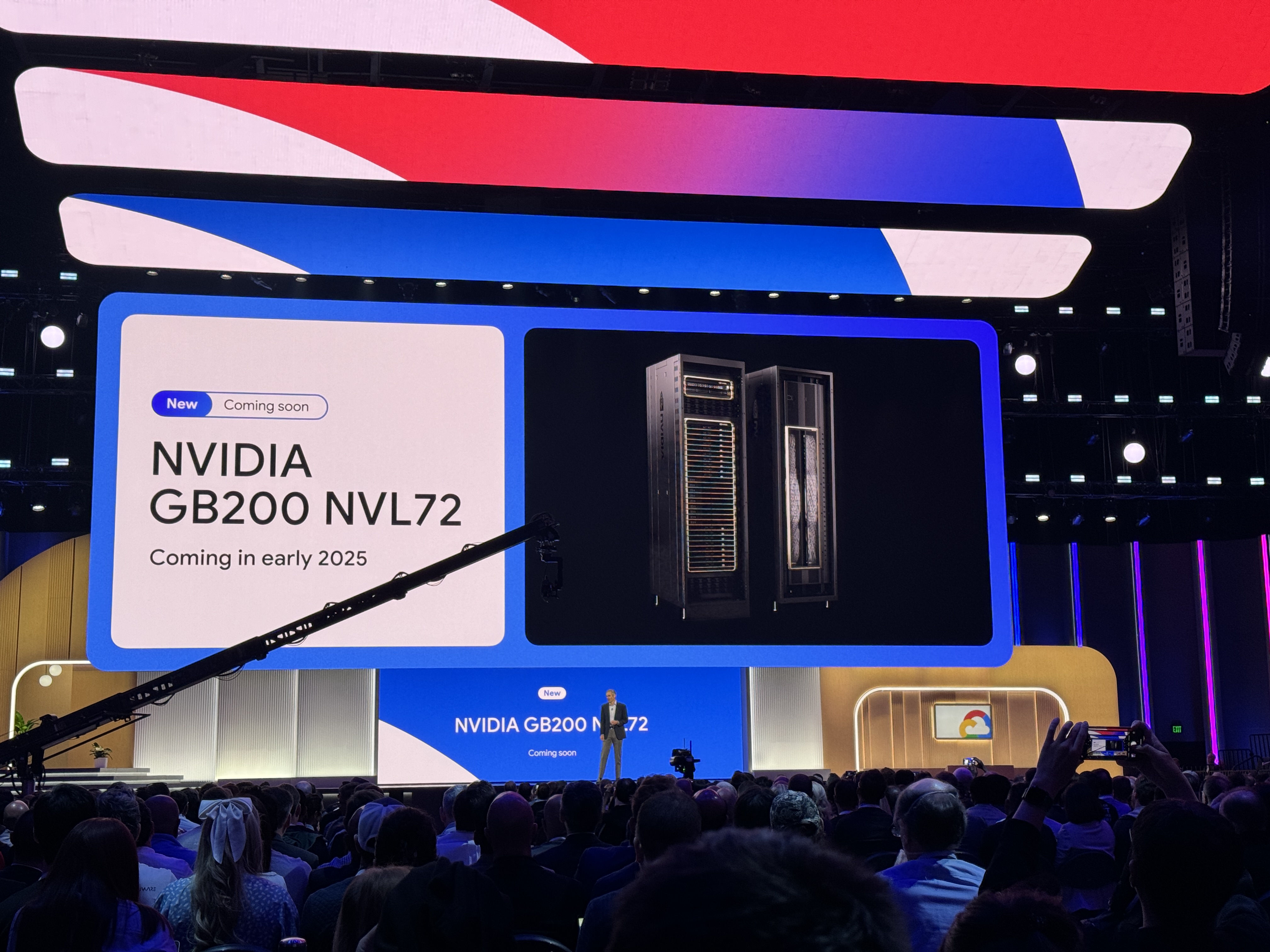

Die nächste Generation des Nvidia Blackwell-Plattform wird Anfang 2025 auf Google Cloud kommen

Es ist Google Cloud Next in Las Vegas diese Woche, und das bedeutet, dass eine Vielzahl neuer Instanztypen und Beschleuniger auf die Google Cloud Platform treffen. Neben den neuen benutzerdefinierten Arm-basierten Axion-Chips sind die meisten Ankündigungen dieses Jahres auf KI-Beschleuniger ausgerichtet, sei es von Google oder von Nvidia.

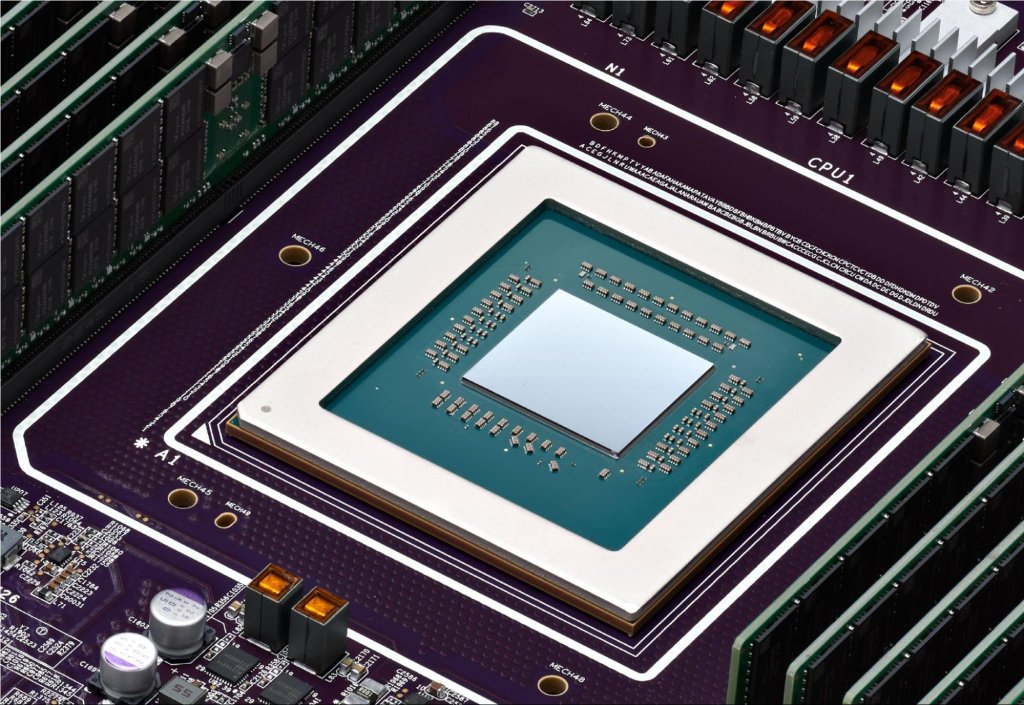

Erst vor wenigen Wochen hat Nvidia seine Blackwell-Plattform angekündigt. Aber erwarten Sie nicht, dass Google diese Maschinen so schnell anbietet. Die Unterstützung für den leistungsstarken Nvidia HGX B200 für KI- und HPC-Workloads und für GB200 NBL72 für das Training großer Sprachmodelle (LLM) wird Anfang 2025 eintreffen. Eine interessante Tatsache aus der Ankündigung von Google: Die GB200-Server werden flüssigkeitsgekühlt sein.

Dies mag nach einer etwas voreiligen Ankündigung klingen, aber Nvidia hat gesagt, dass seine Blackwell-Chips erst im letzten Quartal dieses Jahres öffentlich verfügbar sein werden.

Vor Blackwell

Für Entwickler, die heute mehr Leistung zum Trainieren von LLMs benötigen, hat Google auch die A3 Mega-Instanz angekündigt. Diese Instanz, die das Unternehmen gemeinsam mit Nvidia entwickelt hat, verfügt über die branchenüblichen H100-GPUs, kombiniert mit einem neuen Netzwerksystem, das bis zu doppelt so hohe Bandbreite pro GPU liefern kann.

Eine weitere neue A3-Instanz ist A3 confidential, die von Google beschrieben wird als Kunden die Möglichkeit zu geben, "die Vertraulichkeit und Integrität sensibler Daten und KI-Workloads während des Trainings und der Inferenzierung besser zu schützen." Das Unternehmen bietet schon lange vertrauliche Computing-Dienste an, die Daten in Gebrauch verschlüsseln, und hier, sobald aktiviert, wird das vertrauliche Computing Datenübertragungen zwischen Intels CPU und Nvidias H100 GPU über geschützte PCIe verschlüsseln. Keine Codeänderungen erforderlich, sagt Google.

In Bezug auf Googles eigene Chips hat das Unternehmen am Dienstag seine Cloud TPU v5p-Prozessoren - die leistungsstärksten seiner hausgemachten KI-Beschleuniger - in die allgemeine Verfügbarkeit gebracht. Diese Chips bieten eine Verdoppelung der Gleitkommaoperationen pro Sekunde und eine dreifache Steigerung der Speicherbandbreitengeschwindigkeit.

All diese schnellen Chips benötigen eine zugrunde liegende Architektur, die mit ihnen mithalten kann. Neben den neuen Chips hat Google am Dienstag auch neue KI-optimierte Speicheroptionen angekündigt. Hyperdisk ML, das sich derzeit in der Vorschau befindet, ist Googles Blockspeicherdienst der nächsten Generation, der die Modell-Ladezeiten um bis zu das 3,7-fache verbessern kann, laut Google.

Google Cloud startet auch eine Reihe von traditionelleren Instanzen, betrieben von Intels vierten und fünften Generation Xeon-Prozessoren. Die neuen Allzweck-C4- und N4-Instanzen werden beispielsweise die fünfte Generation der Emerald Rapids Xeons enthalten, wobei sich die C4 auf Leistung und die N4 auf Preis konzentriert. Die neuen C4-Instanzen sind jetzt in der privaten Vorschau, und die N4-Maschinen sind ab heute allgemein verfügbar.

Auch neu, aber noch in der Vorschau, sind die C3-Bare-Metal-Maschinen, betrieben von älteren vierten Generation Intel Xeons, die X4-Speicher-optimierten Bare-Metal-Instanzen (ebenfalls in der Vorschau) und die Z3, Googles erste speicheroptimierte virtuelle Maschine, die "die höchsten IOPS für speicheroptimierte Instanzen unter führenden Clouds" verspricht.

Die Keynote von Nvidia auf der GTC hielt einige Überraschungen bereit